线性回归方程公式详解(全面认识线性回归)

线性回归方程公式详解(全面认识线性回归)

在这篇文章中,你将了解线性回归算法、它的工作原理,以及如何在机器学习项目中更好地运用它。

什么是线性回归?

线性回归是一种基于监督学习的机器学习算法,它执行回归任务。回归基于自变量对目标预测值进行建模,它主要用于找出和预测变量之间的关系。不同的回归模型基于他们正在考虑的因变量和自变量之间的关系类型以及使用的自变量数量而异。

如何定义模型?

线性回归的执行是基于给定的自变量 (x) 预测因变量值 (y) 的任务。

线性回归方程公式如下:

Y = wX + b

其中

X

是自变量,

Y

是因变量。

w

是系数,b是偏差。

计算损失函数

损失函数是均方误差方程。对于监督学习,模型通过找到最小化成本函数的最优系数来优化。成本函数使用损失函数计算的每个数据点的损失总和。

线性回归最常用的损失函数是

最小平方误差

,它的成本函数也称为

均方误差(MSE)

。均方误差的公式为:

其中

n

是数据点的数量,

y

是模型返回的值,

ŷ

是数据点的实际值

。

如何优化回归模型?

梯度下降是一种寻找损失函数的迭代优化算法。当函数达到全局最小值时,它将具有最佳的 w 和 b 值。

梯度下降是一种用于寻找可微函数的局部最小值的优化算法。梯度下降简单地用于机器学习中,以找到尽可能使成本函数最小化的函数参数(系数)值。

实施模型

现在将上面的所有内容都转换为代码,看看我们的模型是如何运行的。

# Making the importsimportnumpyasnpimportpandasaspdimportmatplotlib.pyplotasplt

plt.rcParams['figure.figsize'] = (12.0,9.0)

# Preprocessing Inputdatadata= pd.read_csv('data.csv')

X =data.iloc[:,0]

Y =data.iloc[:,1]

plt.scatter(X, Y)

plt.show()

# Building the modelm=0c=0L=0.0001# The learning Rateepochs=1000# The number of iterations to perform gradient descentn=float(len(X))# Number of elements in X# Performing Gradient Descentforiinrange(epochs):Y_pred=m*X+c# The current predicted value of YD_m=(-2/n)*sum(X*(Y-Y_pred))# Derivative wrt mD_c=(-2/n)*sum(Y-Y_pred)# Derivative wrt cm=m-L*D_m# Update mc=c-L*D_c# Update cprint(m,c)

1.47964916888893950.10148121494753726#(m = w et c = b)

# Making predictions Y_pred = m*X + c plt.scatter(X, Y) plt.plot([min(X),max(X)], [min(Y_pred),max(Y_pred)], color='red') # regression line plt.show()

-

- 体育生可以考哪些大学哪些专业(统招体育生可以报考哪类大学和专业?)

-

2023-12-31 18:21:08

-

- 上吐下泻吃什么好 上吐下泻的原因是什么

-

2023-12-31 18:18:53

-

- 千斤拔 中药材千斤拔 消瘀解毒 治风湿痹痛

-

2023-12-31 18:16:38

-

- 烤箱如何烤面包 教你在家做简易面包,孩子爱吃

-

2023-12-31 18:14:23

-

- 金针菇发黄了还能吃吗?金针菇怎么保存时间长?

-

2023-12-31 18:12:09

-

- 自己炒板栗怎么炒 秋天吃栗子在家自己炒,不用糖不用砂,香甜粉糯,个个开口好

-

2023-12-31 18:09:54

-

- 怎样管教孩子最有效 管住这三点就行了,想不成功都难

-

2023-12-31 18:07:39

-

- 幼儿急疹出疹后护理 家庭护理是关键,这里有五个幼儿急疹护理的小妙招

-

2023-12-31 18:05:25

-

- 如何在工作中提升自己的能力 ,让自己不可替代,早晚混出头

-

2023-12-31 07:45:01

-

- 如何缴纳公积金 极干货|聊一聊:员工离职当月的住房公积金该如何缴纳?

-

2023-12-31 07:42:46

-

- 尿道炎饮食 改善尿道发炎10个饮食步骤

-

2023-12-31 07:40:32

-

- 发乎情止乎礼什么意思(不要在微信上这样“称呼”对方)

-

2023-12-31 07:38:17

-

- hdmi接口长啥样 DP接口和HDMI接口的区别有哪些?

-

2023-12-31 07:36:02

-

- 支气管炎的症状表现在哪些方面(支气管炎的症状表现有哪些:是什么因素引起你

-

2023-12-31 07:33:48

-

- 维吾尔族的风俗习惯(维吾尔族的民族风俗了解一下!)

-

2023-12-31 07:31:33

-

- 墨鱼最佳搭配,吃了20多年,鲜香味美营养全面

-

2023-12-31 07:29:18

-

- 粉条怎么泡水正确方法(红薯粉丝泡多长时间,把时间和水温掌握好,后期烹饪才

-

2023-12-31 07:27:03

-

- 羊肉饺子馅的配料 , 常见的羊肉饺子馅的做法

-

2023-12-31 07:24:48

-

- 黑群晖安装教程(黑群晖安装教程 2019)

-

2023-12-30 09:30:57

-

- ovv女装属于什么档次(ovv女装属于几线牌子)

-

2023-12-30 09:28:42

海角论坛网页版怎么进入

海角论坛网页版怎么进入 大连到上海的船票时刻表

大连到上海的船票时刻表 小手的全部小说作品

小手的全部小说作品 输入真实姓名网上找人户籍网(网上办理户籍业务)

输入真实姓名网上找人户籍网(网上办理户籍业务) 高压锅煮饭响后几分钟(高压锅响了马上关小火吗)

高压锅煮饭响后几分钟(高压锅响了马上关小火吗) 广州荔湾广场灵异事件,每年有人自杀传言挖出了八副棺材(谣言)

广州荔湾广场灵异事件,每年有人自杀传言挖出了八副棺材(谣言) 云南昆明一年四季的温度怎么样(昆明一年四季的温度)

云南昆明一年四季的温度怎么样(昆明一年四季的温度) the cure为什么是考试神曲

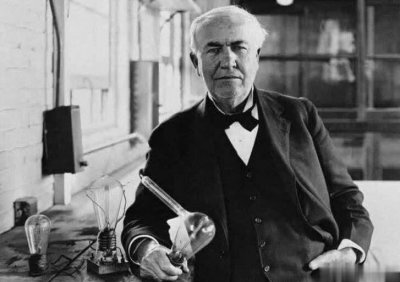

the cure为什么是考试神曲 爱迪生发明电灯的过程 13个月试用了6000 多种材料试验了7000多次

爱迪生发明电灯的过程 13个月试用了6000 多种材料试验了7000多次 咸鸭蛋的吃法

咸鸭蛋的吃法